মানুষের জীবনযাত্রা সবচেয়ে সহজ, সাবলীল এবং তাৎপর্যপূর্ণ করেছে বিজ্ঞান ও প্রযুক্তি। আবার মানুষের জীবনকে এমনকি মানব সভ্যতাকে চরম বিরক্তিকর ও ধ্বংসের দ্বারপ্রান্তে এনে দাঁড় করিয়েছেও এই বিজ্ঞান ও প্রযুক্তি। অর্থাৎ প্রযুক্তিতেই উত্থান ও প্রযুক্তিতেই সর্বনাশ। সেই অতীতকাল থেকেই কারও বিরুদ্ধে ইচ্ছাকৃত কুৎসা রটানো, মিথ্যা প্রচার করা এবং কাউকে হেয় করার প্রবণতা মানুষের মাঝে ছিল এবং এখনো আছে। শুধু সময়ের পরিবর্তনের ফলে মাধ্যমের পরিবর্তন ঘটেছে। গুজব রটিয়ে কোনো ব্যক্তিকে বা কোনো গোষ্ঠীকে বা কোনো দলকে সামাজিকভাবে, মানসিকভাবে দুর্বল করে দেওয়ার প্রবণতাও প্রচুর। এক্ষেত্রে এতদিন বেছে নেওয়া হয়েছে সামাজিক যোগাযোগ মাধ্যম। আবার একসময় একজনের ছবি কেটে নিয়ে অন্যজনের ছবিতে নিখুঁতভাবে বসিয়েও কারসাজি করা হয়েছে। সেটাও একটি প্রযুক্তি। এসব কিন্তু কোনোদিনও থেমে থাকবে না। সময়ের সঙ্গে সঙ্গে প্রযুক্তির আধুনিকায়নের সঙ্গে এসব অপপ্রচারের ধরনও হবে সাংঘাতিক। ইতিমধ্যেই আমরা সেসব টের পাচ্ছি। এত নিখুঁতভাবে ভিডিও তৈরি করা হচ্ছে যে, কারও পক্ষে প্রথমে ধরার উপায় থাকে না এটি আসল নয়, ফেক বা নকল বা ইচ্ছাকৃত। ইদানীংকালে ডিপফেক ভিডিওর মাধ্যমে এই কাজটি বেশি করা হচ্ছে। এর ফলে অন্য কোনো আপত্তিকর বক্তব্য বা কাজ বা ভিডিও আমার মুখ দিয়ে ইচ্ছাকৃতভাবে করানো। মানুষ যখন সেটা দেখবে প্রথমেই বেশিরভাগেরই ধরার ক্ষমতা থাকে না যে, সেটি একটি ডিপফেক ভিডিও। বা আপনি-আমি এর শিকার। কারণ বেশিরভাগ মানুষ প্রথমেই ঘটনাটিকে সত্যি ঘটেছে বলেই ধরে নেয়। কারণ ভিডিও মানুষ বেশি বিশ্বাস করে। অনেকে তো জানেও না যে, এভাবে ইচ্ছাকৃতভাবে ভিডিওতে কারসাজির মাধ্যমে কিছু করা সম্ভব হয়। বিশ্বজুড়েই এখন একটি আতঙ্কের নাম এই ডিপফেক।

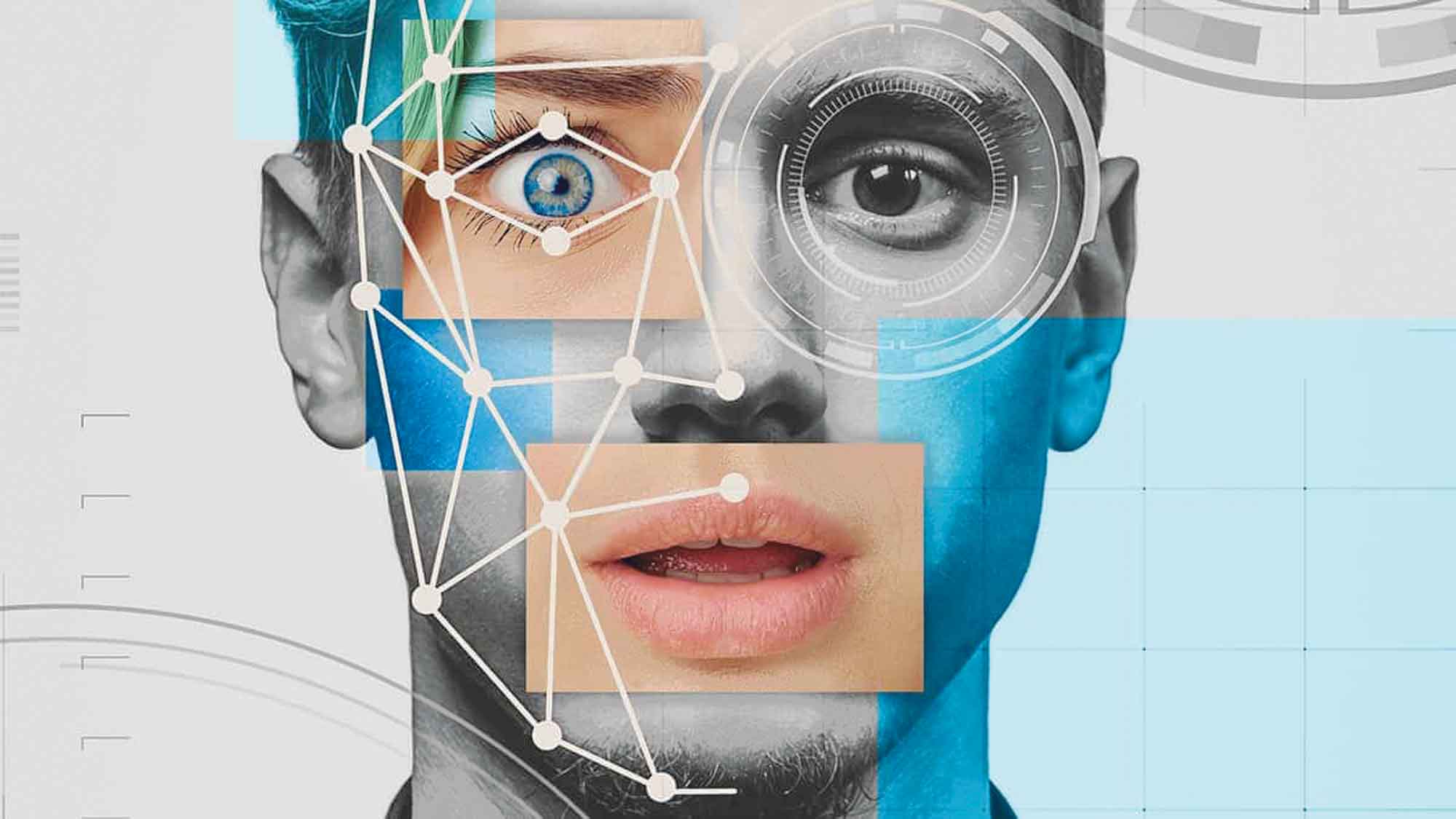

ইদানীংকালে অর্থাৎ এই আর্টিফিশিয়াল ইন্টেলিজেন্স এর জয়জয়কারের যুগে যে বিষয়টি প্রায় প্রতিনিয়তই আলোচিত হচ্ছে সেটি ডিপফেক শব্দ। এই ডিপফেকের কবলে পরে নামিদামি তারকারা, রাজনীতিবিদ থেকে শুরু করে সবাই হয়রানির শিকার হচ্ছেন। ভারতীয় অভিনেত্রী, ধনকুবের থেকে শুরু করে খোদ প্রধানমন্ত্রী নরেন্দ্র মোদিকে ডিপফেক (কৃত্রিম বুদ্ধিমত্তার সহায়তায় তৈরি নকল অবয়ব) ভিডিওর শিকার হতে হয়েছে। ২০১৮ সালের মে মাসে সাবেক মার্কিন প্রেসিডেন্ট ডোনাল্ড ট্রাম্পের একটি ডিপফেক ভিডিও ইন্টারনেটে ছড়িয়ে পড়ে। নারীরা এ প্রযুক্তির শিকার হচ্ছেন বেশি। নারীদের মুখের ছবি নিয়ে বানানো হচ্ছে অ্যাডাল্ট ভিডিও এবং তা অনলাইনে ছড়িয়ে দেওয়া হচ্ছে। এমন এক অবস্থা যে এক মুহূর্তেই আপনি হিরো থেকে তলানিতে ঠেকছেন। অথচ সেটি আপনি না বা আপনি আদৌ সেই ভিডিওর বিষয়ে কিছুই জানেন না। আগে জানা যাক এই ডিপফেক আসলে কী? শব্দটি ইংরেজি ফববঢ়ভধশব থেকে এসেছে। বাংলাতেও ডিপফেক বলা হয়। একটু গভীরভাবে দেখলেই বোঝা যাবে এই শব্দটিকে অনায়াসে ভাঙা যায়। ডিপ এবং ফেইক। ডিপ অর্থ গভীর এবং ফেইক অর্থ মিথ্যা বা প্রতারণা ইত্যাদি। অর্থাৎ পুরো বিষয়টিই বড় ধরনের জালিয়াতি যা উদ্দেশ্যমূলকভাবে ঘটানো হচ্ছে। প্রশ্ন হলো, এটি কিসের সাহায্যে ঘটানো হচ্ছে এত সহজে? এটা ঘটানো হচ্ছে এআই অর্থাৎ কৃত্রিম বুদ্ধিমত্তার সাহায্য নিয়ে। একটি পুরোপুরি মিথ্যা ঘটনাকে উদ্দেশ্যমূলকভাবে ছড়িয়ে ব্যক্তির সুনাম ক্ষুণ্ন করাই হলো ডিপফেক। ডিপফেক হলো এমন একটি প্রোগ্রাম যা আর্টিফিশিয়াল ইন্টেলিজেন্সের একটি ধরন 'ডিপ লার্নিং টেকনোলজি' ব্যবহার করে তৈরি করা হয়। মূলত এই পদ্ধতিতে অডিও, ভিডিও এবং ছবিতে কারসাজি করে এমন কনটেন্ট বানানো হয়, যা দেখে আসল কি নকল তা বোঝার উপায় থাকে না। ডিপফেক টেকনোলজি সর্বপ্রথম ২০১৭ সালে প্রচারণা পায় আর্টিফিসিয়াল ইন্টেলিজেন্সের মাধ্যমে অত্যন্ত বাস্তব; কিন্তু প্রচন্ড ভুয়া ছবি, অডিও, ভিডিও এবং অন্য ধরনের জালিয়াতির মধ্য দিয়ে। মেশিন লার্নিং প্রয়োগের মাধ্যমে দিন দিন প্রযুক্তিটি আরও উন্নত হচ্ছে এবং নিখুঁতভাবে নকল ভিডিও বানানো হচ্ছে। এতটাই নিখুঁত যে এটি প্রমাণ করা বেশ কষ্টসাধ্য যে ভিডিওটি কৃত্রিম বুদ্ধিমত্তার সাহায্যে বানানো হয়েছে।

খালি চোখে দেখে বোঝার উপায় নেই এটি নকল; কিন্তু আসলে এটি একটি মিথ্যা ভিডিও। কারণ এখানে ঠোঁটের নড়াচড়া থেকে শুরু করে সব অঙ্গভঙ্গি এবং মানুষের ছায়ারও নকল করা হয়। বিভিন্ন দেশ ইতিমধ্যেই বিষয়টি নিয়ে কঠোর অবস্থানে গেছে। বেশিরভাগ ডিপফেক ভিডিও এবহবৎধঃরাব অফাবৎংধৎরধষ ঘবঃড়িৎশ (এঅঘং)-এর মাধ্যমে বানানো হয়। যেটির মধ্যে দুটি গধপযরহব ষবধৎহরহম সড়ফবষ কাজ করে। এদের একটি হচ্ছে, এবহবৎধঃড়ৎ এবং অন্যটি হচ্ছে উরংপৎরসরহধঃড়ৎ। আপনি যেই প্রোগ্রামটির মধ্যে দিয়ে কোনো ডিপফেক ভিডিও বানাবেন, সেখানে কোন ছবি কিংবা ভিডিও দেওয়ার পর এবহবৎধঃড়ৎ সেগুলোকে এনালাইসিস করে এবং সেগুলোর ওপর ভিত্তি করে একটি নকল ভিডিও তৈরি করে। তারপর সেসব প্রচার করে। সামাজিকভাবে হেয় করা বা কাউকে সমাজের চোখে ছোট করা ইত্যাদি ঘৃণ্য কাজগুলো করতে এসব করছে। যারা এসব করছে তারাও কিন্তু প্রযুক্তির ব্যবহার করতে বেশ দক্ষ! তবে সেই দক্ষতা তারা কাজে লাগাচ্ছেন ভালো কাজে নয়, মন্দ কাজে। ডিপফেক প্রযুক্তি কাল্পনিক ছবি, 'মর্ফড' ভিডিও যেমন বানাতে পারে, তেমনই কণ্ঠস্বরও নকল করতে পারে। আপনি বুঝতেই পারবেন না সেই কণ্ঠস্বর সেই ব্যক্তির নয়। এআই কাজে লাগিয়ে তৈরি করা হয়েছে! তবে বিশেষজ্ঞদের বিশ্লেষণ থেকে কিছুটা ধারণা পাওয়া যায় যে, আমরা কিভাবে বুঝতে পারি এটি আসল ভিডিও নাকি নকল? অর্থাৎ যে ব্যক্তিকে ভিডিওতে দেখা যাচ্ছে সেটি তারই কি না তার যাচাই করতে পারি। যদিও তা অনেকটাই কষ্টসাধ্য। যেমন কৃত্রিমভাবে তৈরি করা এসব ভিডিওতে ব্যক্তি মুখের বা ঠোঁঠের মুভমেন্টের সঙ্গে কথার মিল সমানতালে বা স্বাভাবিকভাবে হয় না। কারণ কথার সঙ্গে শারীরিক অঙ্গভঙ্গি বা নড়াচড়া ইত্যাদি যেভাবে হওয়ার কথা সেভাবে হবে না। একটু অদ্ভুত লাগবে। আবার দেখার সঙ্গে সঙ্গেই বিশ্বাস করার কোনো দরকার নেই। আপনাকে বুঝতে হবে যে, সেই কথা বা কাজ সেই ব্যক্তি করতে পারেন কি না। এছাড়া ডিপফেক ভিডিও শনাক্ত করার প্রযুক্তিও রয়েছে। তবে সতর্কতাই সবচেয়ে বড় উপায়। প্রযুক্তির উত্থানের এই যুগে আপনি আমি কেউই নিরাপদ নই। আবার প্রযুক্তি থেকে দূরেও সরে থাকতে পারব না। ফলে একটু সাবধানতা তো অবলম্বন করতেই হবে। না করলেই যেকোনো সময় বিপদে পড়ার সম্ভাবনা রয়েছে।